先に作った Hyper-V 環境下の PVE と併せて 3 台のクラスタを構成する。

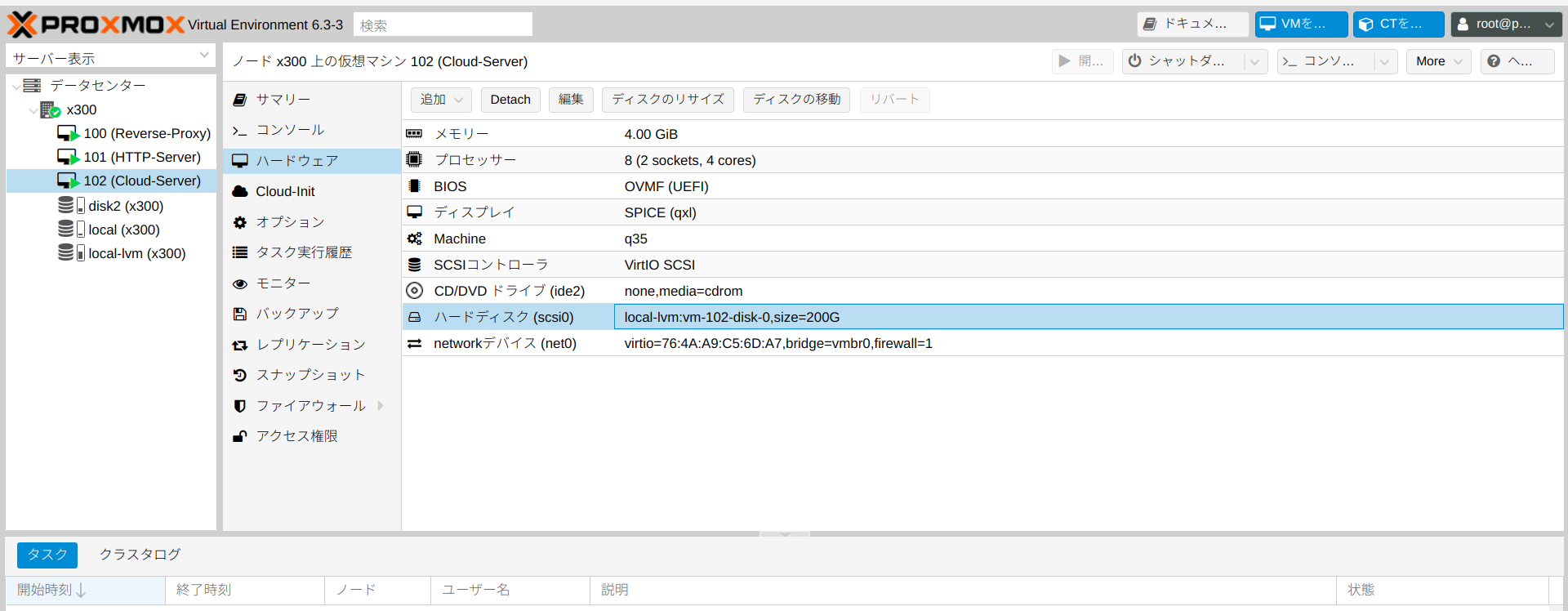

仮想マシンの作成

DeskMini X300 と H470 に、それぞれ仮想マシンを作って PVE をインストールする。構成としては、

- メモリー : 8GB

- CPU : 8CPU(2 ソケット、4 コア)

- ストレージ : 32GB(OS 用)、64GB(ceph用)

入れ子の仮想化環境でも遅いなりに Ubuntu Server 20.04.2 のインストールは可能で Apache も動作した。

クラスタの作成、ノードの追加

こちらの記事のとおり。

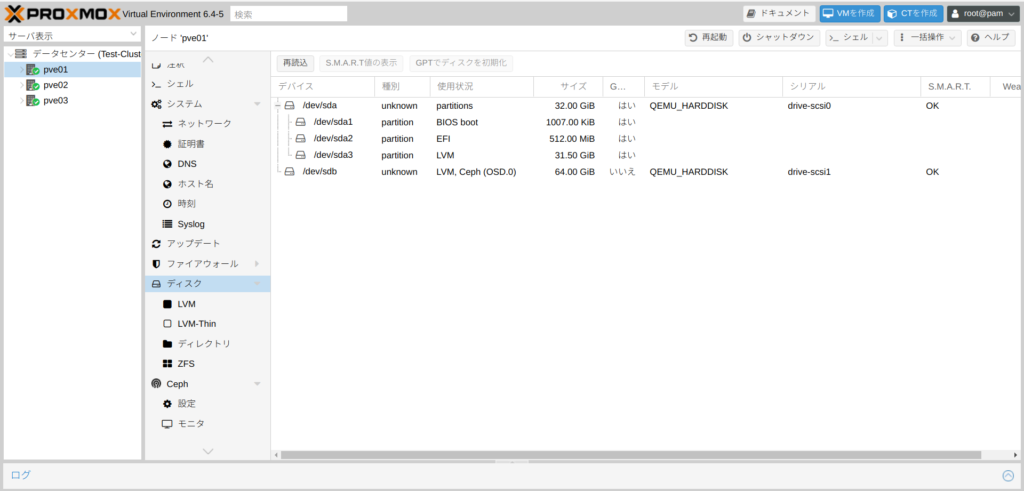

HDD の追加

ceph はドライブまるごと使用するから、各ノード(仮想マシン)に 64G のストレージを追加する。動作確認用に Ubuntu Server をインストールするだけなら十分。

ceph 導入

参考としたサイトなど

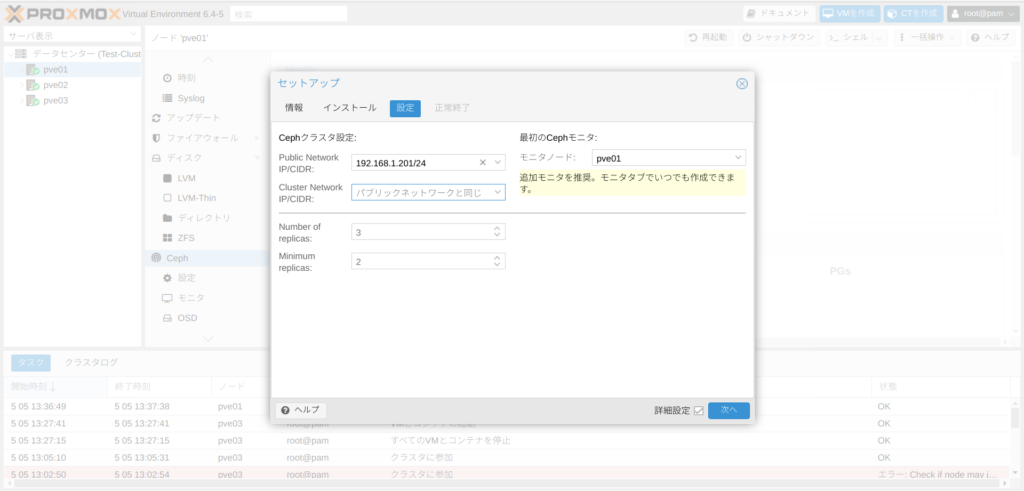

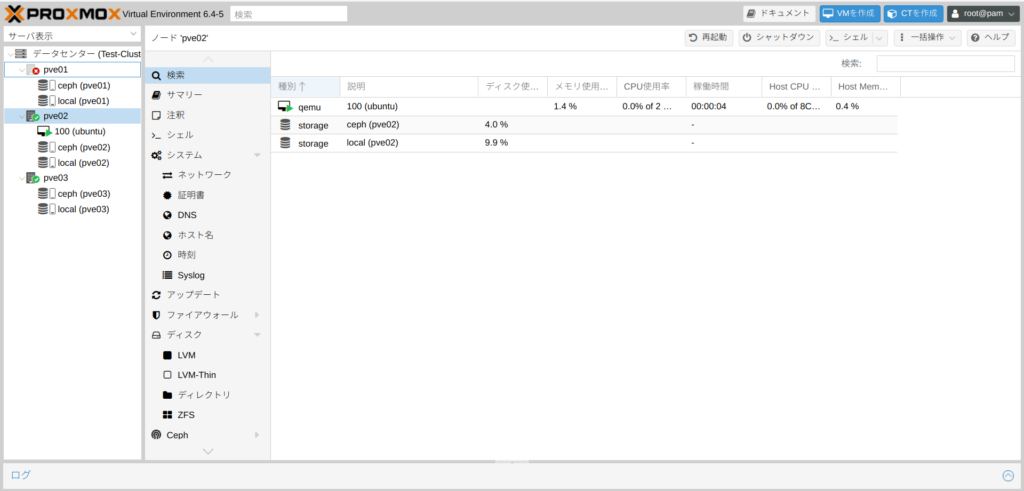

クラスタの構成は最低限必要な3台。

ネットワークは ceph 用と管理用を分けるべきだろうけど、そもそも物理 NIC は各 PC それぞれ1個しかないから全て同じネットワークのまま。

- ノード PVE01 : IP アドレス 192.168.1.201/24・メモリ 8G・CPU 8(2x4)

- ノード PVE02 : IP アドレス 192.168.1.202/24、メモリ 8G・CPU 8(2x4)

- ノード PVE03 : IP アドレス 192.168.1.203/24、メモリ 4G・CPU 8(2x4)

Proxmox インストール直後の様子はこれ。

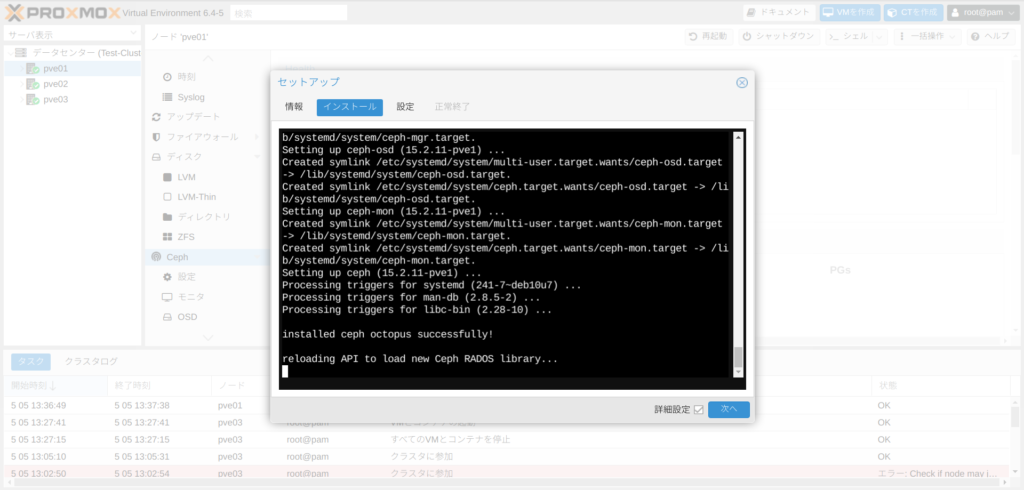

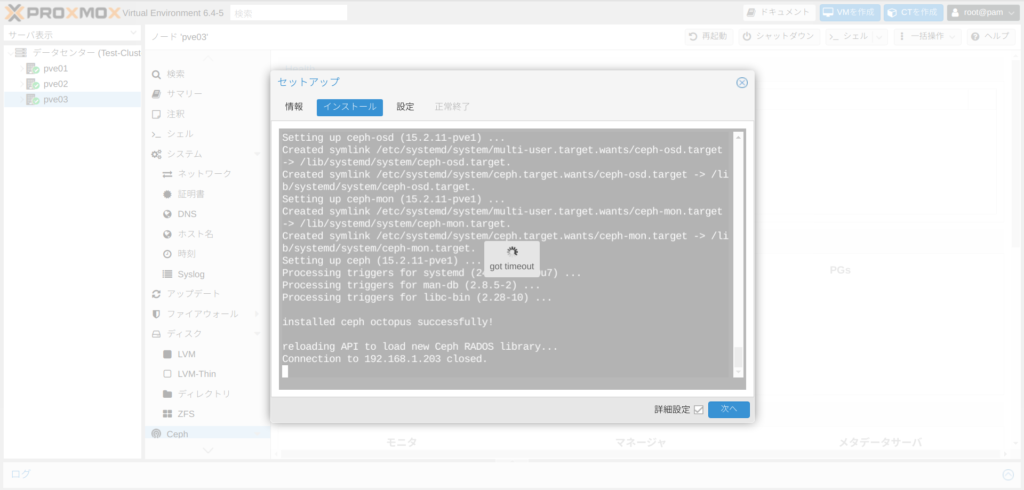

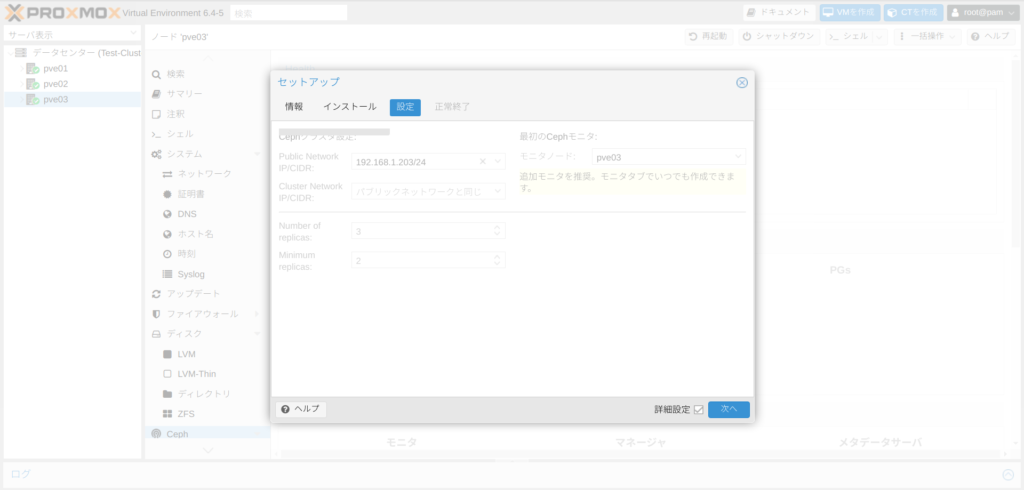

ceph インストール

最初のノードの ceph インストール中の画面。ダイアログの右下の「次へ」がアクティブ(濃い青)になったらクリックして次に進む。

今更だけど、スクリーンショットを撮るときは画面を最大化すると不要なメニューを切り取らなくていいから次回からそうしよう。

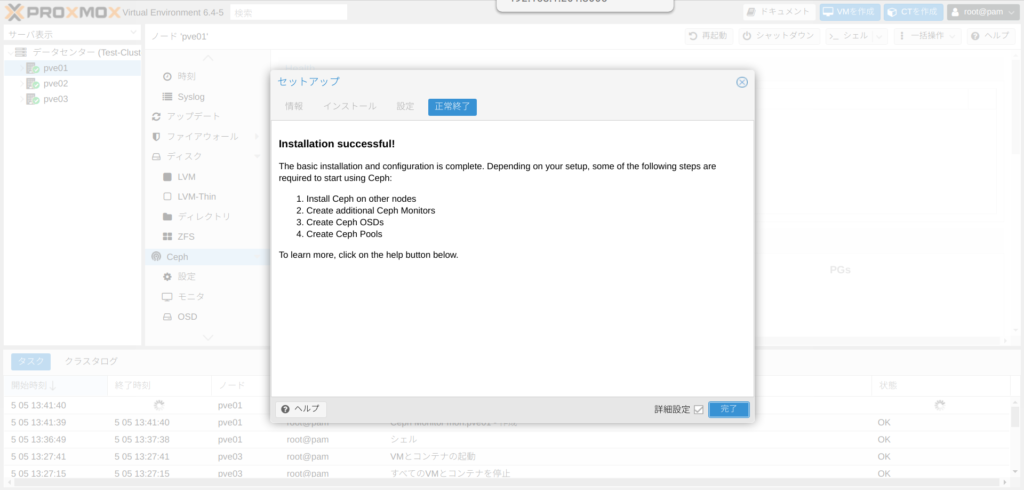

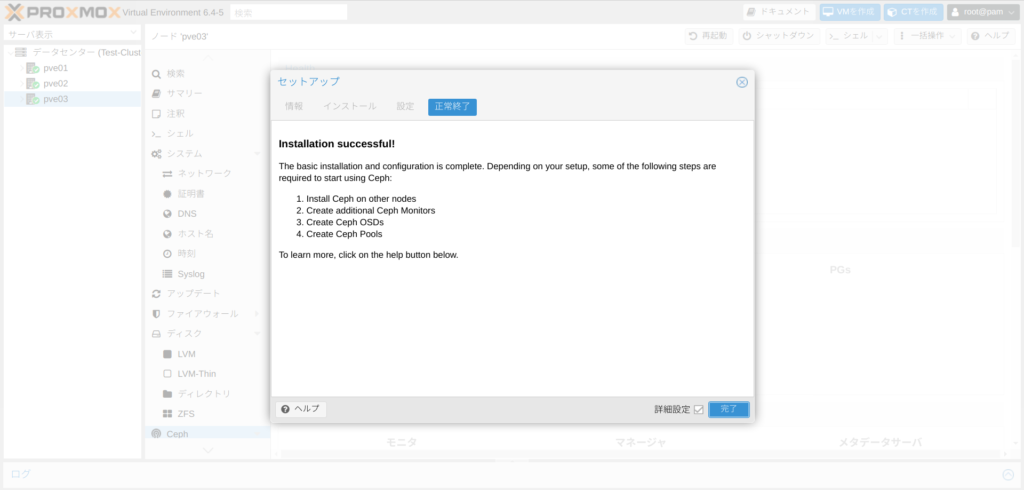

2つ目以降のノードも同じように ceph をインストールする。途中、画面がグレーアウトしても大丈夫。「次へ」で完了する。モニターとマネージャーもそれぞれ各ノードを登録する。

ceph のインストール完了後の画面。HEALTH_WARN はこの段階では問題ない。(OSD がまだ無いので)

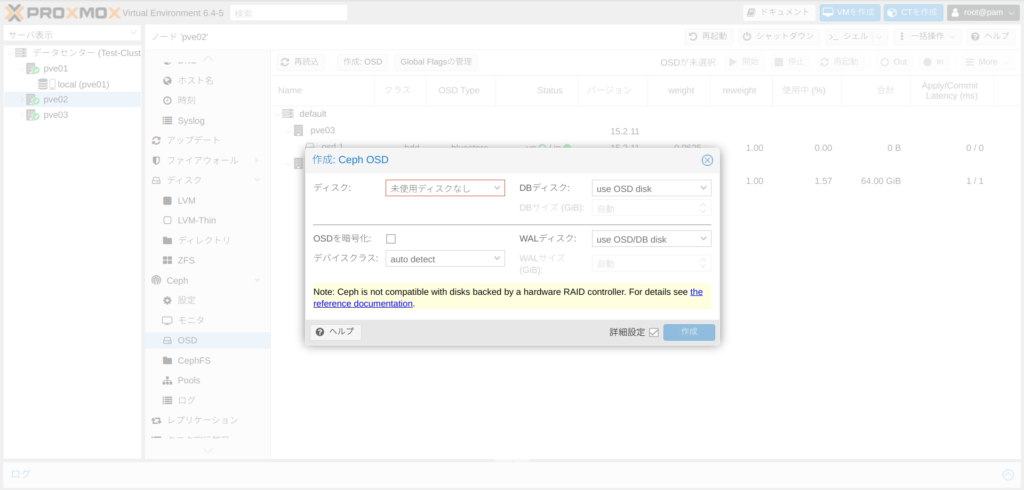

OSD 登録

続いて管理画面の各ノードで OSD を登録する。

Ceph/RBD pool の作成

インストール用のイメージファイルは local に保存するから CephFS は作らない。

もしノードの「灰色?」マークが消えないときはコンソールから

service pvestatd restartOSD、Ceph/RDB pool 登録後。

これで、仮想マシンをインストールするときにストレージとして ceph を選択できるようになる。

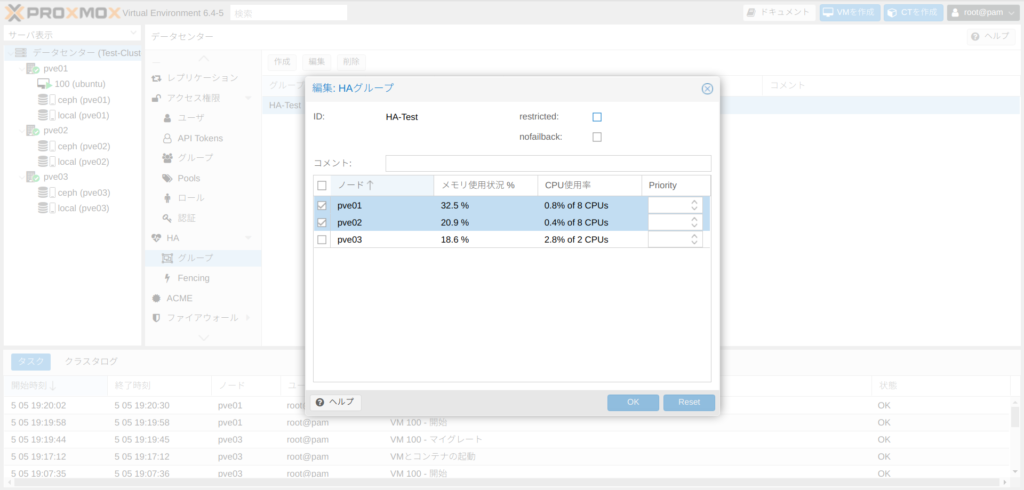

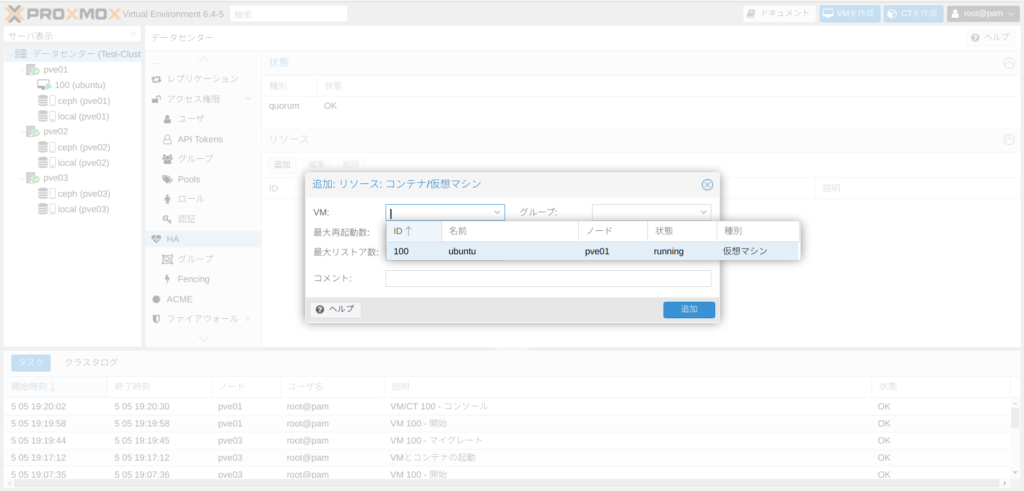

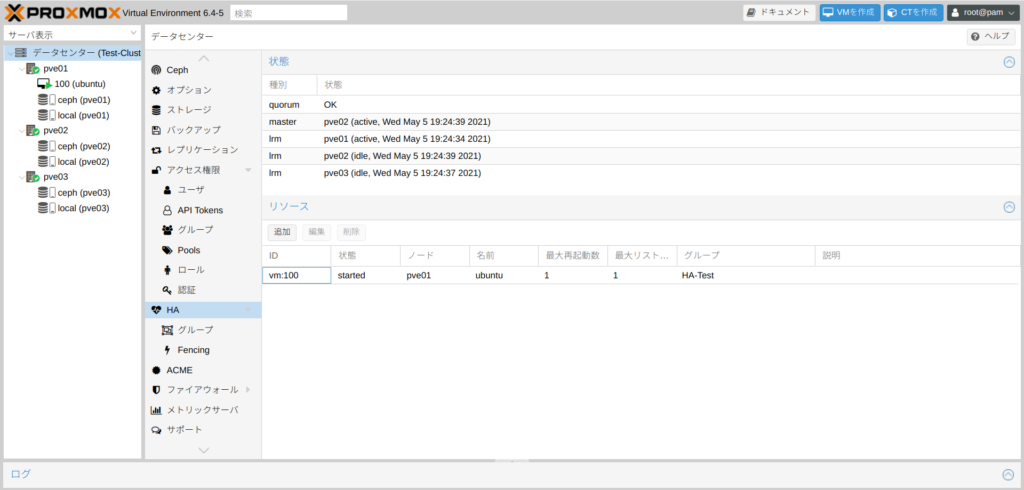

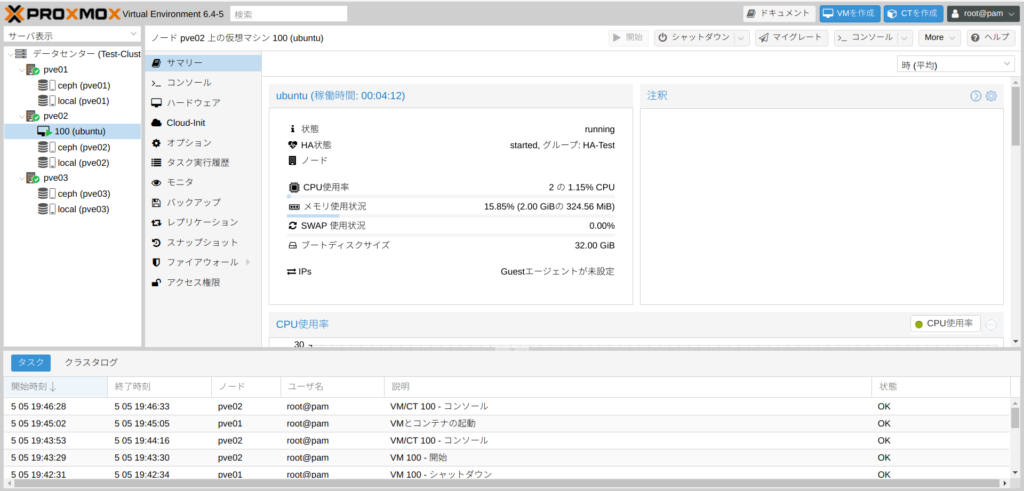

HA(High Availability)

こちらは管理画面のデータセンターから HA を選択してリソース(仮想マシン)を追加すればよい。

事前にグループとしてノードを登録しておくと、3ノードのうち2ノードで運用するといったことが可能。

物理ホストの Proxmox でゲストの仮想マシン PVE01 をシャットダウンすると、入れ子になったゲストの孫仮想マシン(ubuntu)が PVE02 に僅かなダウンタイムでマイグレーションされる。

おわりに

物理マシンのうち1台が壊れたときでも DeskMini X300 と H470 の間でマイグレーションできれば運用上問題ない。Windows の Hyper-V 環境にインストールした Proxmox は、3台という要件を満たすために準備する、ということで実機でも何とかなりそうだな。

ただ、各物理マシンの ceph 用 SSD は同一容量にしたほうが良いらしいし、全ての仮想マシンを HA で運用する必要はないしということで、もう少し構成は考えたほうが良さそうだ。

-1024x490.png)

-1024x490.png)

コメント